Psicologia e agenti virtuali: un legame inaspettato ma essenziale

Come la psicologia rende l'intelligenza artificiale più umana ed efficace.

Quando si pensa alla psicologia è naturale pensare subito alla mente umana, perché è lei il centro di questa disciplina, ed è lei che si cerca di comprendere. Ma le sfumature e le possibili applicazioni delle scienze psicologiche sono molto più ampie e diversificate.

Negli ultimi anni l'arrivo dell'intelligenza artificiale ha rivoluzionato molti aspetti della nostra vita quotidiana. Allo stesso tempo, però, ha fatto emergere nuove riflessioni, nuove esigenze e nuove responsabilità.

È proprio qui che entra in gioco il legame inaspettato ma fondamentale, tra psicologia e AI. Per garantire un'interazione, un dialogo che sia efficace, naturale e privo di incomprensioni con una "mente" artificiale, prima è indispensabile conoscere a fondo quella umana.

Creare un benchmark: da dove si parte?

Così è iniziata la mia esperienza di tirocinante all'interno di AND EMILI dove ho avuto l'occasione di contribuire alla creazione di benchmark per una serie di agenti virtuali. Il primo passo è stato immergermi nelle conversazioni quotidiane tra gli agenti virtuali e gli utenti, per capirne la qualità e coglierne i limiti. Dovevo individuare gli aspetti da migliorare e affinare.

Le conversazioni che ho esaminato erano già anonimizzate, tutti i dati sensibili venivano automaticamente rimossi. Un processo necessario per garantire il rispetto della privacy, che avveniva dietro le quinte attraverso sistemi di entity extraction e NLP.

Ho analizzato centinaia di conversazioni osservando come si sviluppano, come e dove nascono equivoci, dove manca empatia o chiarezza. Il mio obiettivo era ottimizzare l'esperienza dell'utente, rendendo l'agente non solo più informativo, ma anche più umano. Un agente capace di adattarsi al tono emotivo della situazione, che sappia contenere la frustrazione, che risponda con precisione e sensibilità.

Come orientarsi tra migliaia di conversazioni?

Inizialmente pensavo che analizzare così tante interazioni sarebbe stato complicato. In realtà, siccome le conversazioni erano già state organizzate automaticamente, potevo visualizzare:

- quelle in cui l’utente si poneva in modo negativo

- quelle su specifici argomenti

- quelle dove l'utente aveva espresso insoddisfazione.

- quelle classificate dall’AI come potenzialmente incomplete

Per rendere l’analisi ancora più semplice sono stata “aiutata” da sistemi che leggevano ogni conversazione identificando quando qualcosa poteva essere andato storto, questo anche quando l’utente non sembrava particolarmente frustrato.

C’era un’enorme quantità di materiale, ma era già stato organizzato, categorizzato meticolosamente.

Mentre esaminavo le singole conversazioni per capirne le sfumature, altri sistemi elaboravano centinaia di migliaia di interazioni identificando il tipo di richieste a cui non veniva data risposta, quali argomenti generavano più confusione e la tipologia di utenti che avevano più difficoltà.

È stato interessante vedere come diversi strati di intelligenza artificiale collaborassero per identificare criticità che altrimenti sarebbero passate inosservate.

L'agente virtuale…ero io

Successivamente mi sono messa io stessa nei panni dell'agente virtuale. Ho riletto le conversazioni che erano state identificate come più frequenti, e una ad una, ho annotato le risposte che avrei dato se fossi stata al suo posto, cercando sempre di rispettare i criteri imposti dall'obiettivo.

È stato un lavoro creativo e analitico allo stesso tempo. Ho cercato di costruire risposte esaustive basate esclusivamente sulle informazioni e i contenuti di cui l'utente aveva bisogno, utilizzando un linguaggio chiaro ed un tono empatico che potesse rispondere adeguatamente al tono emotivo dell'utente.

Durante questo processo, mi sono resa conto di quante sfumature entrano in gioco in ogni risposta: quando essere più formali, quando esserlo meno, quando fornire informazioni aggiuntive e quando invece essere concisi, come gestire la frustrazione di un utente senza cadere nella condiscendenza.

Queste sono tutte accortezze di cui non ci rendiamo conto perché nella conversazione umana sono innate, naturali. Ma quando si tratta di addestrare un'AI vanno prese in considerazione.

Pattern e tendenze

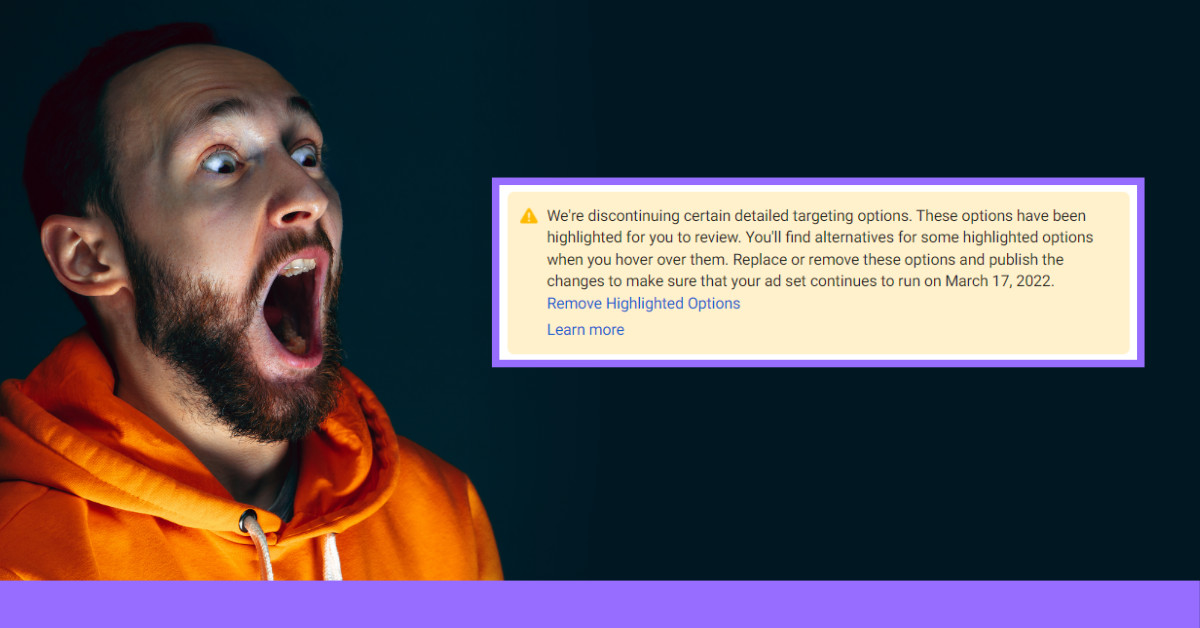

Man mano che procedevo con l'analisi, iniziavano a emergere fenomeni frequenti. Certi tipi di domande ricevevano sistematicamente risposte inadeguate, non per limiti dell'agente ma perché non possedeva le informazioni necessarie. Altri problemi nascevano quando gli agenti non riconoscevano il contesto emotivo della conversazione, la risposta era corretta dal punto di vista tecnico, ma con un tono sbagliato.

I casi problematici erano una minoranza, ma ho scelto di concentrarmi su questi perché mi avrebbero dato informazioni più significative su cosa andava perfezionato.

La maggior parte delle interazioni era positiva, mostrava che gli agenti se la cavavano piuttosto bene. I problemi principali sono emersi quando gli utenti facevano domande su informazioni che non erano presenti nel database dell'agente.

Ma c'erano anche casi più sottili: conversazioni apparentemente normali dove però i chatbot avevano frainteso il contesto o fornito informazioni tecnicamente corrette ma non pertinenti alla domanda specifica. Questi casi venivano segnalati automaticamente anche quando l'utente non si lamentava esplicitamente.

È stato interessante notare come gli agenti, anche quando non avevano la risposta precisa, cercassero comunque di essere utili, a volte con un relativo successo, altre volte creando più confusione.

Questi erano i casi più istruttivi: capire dove e perché la conversazione deragliava aiutava a identificare sia le informazioni mancanti che la tipologia di “comportamenti” da correggere.

Il fattore umano nell'AI

Il passaggio finale è stato confrontare le mie risposte con quelle reali fornite dai chatbot. Questo confronto sistematico ha permesso di identificare con precisione dove e come intervenire.

A volte la soluzione era semplice: aggiungere informazioni mancanti. Altre volte era necessario ripensare l'approccio comunicativo dell'agente in determinati contesti.

Un aspetto che mi ha colpito è stato quanto il tono emotivo influenza l'efficacia della comunicazione. Due risposte con lo stesso contenuto informativo potevano avere effetti completamente diversi a seconda di come venivano formulate.

Nel confronto con un utente frustrato, generare una risposta corretta e precisa nei contenuti, ma fredda nel tono sarebbe sbagliato. Bisogna invece cercare di contenere la frustrazione mostrata generando una risposta che sia anche empatica.

Questa sensibilità al contesto emotivo è qualcosa che diamo per scontato nelle interazioni umane, ma che richiede un'attenzione particolare quando si progettano sistemi di AI conversazionale.

Due mondi, più vicini di quanto sembra

Per me, questa è stata un'esperienza incredibilmente formativa. Non solo ho avuto l'opportunità di applicare parte delle competenze acquisite nel mio percorso di studi in psicologia, ma l'ho fatto partecipando ad un progetto complesso, innovativo, e profondamente radicato nel presente (e nel futuro).

Ho avuto la possibilità di esplorare e conoscere dall'interno il mondo dell'intelligenza artificiale, che è in continua espansione. Ho scoperto quanto è già parte della nostra quotidianità e quanto, inevitabilmente, continuerà ad esserlo.

Ma soprattutto, ho capito come anche la tecnologia più sofisticata abbia bisogno dell'intuizione e della comprensione umana per funzionare davvero bene. Quando si tratta di interagire con l’essere umano è proprio quest’ultimo che diventa fondamentale nell'ottimizzazione di ciò che umano non è.

Anche se a prima vista l'intelligenza artificiale può sembrare distante dalle qualità e dalle caratteristiche che consideriamo proprie dell'essere umano (creatività, empatia, intuito…), in realtà non può esistere senza di esse.

L'intelligenza artificiale nasce, cresce e si evolve dentro un contesto puramente umano: è modellata, plasmata, guidata dalla nostra mente. Ed è proprio per questo che la psicologia non è solo utile, ma fondamentale per rendere l'AI più efficace, più comprensibile e forse anche un po' più umana.

Il futuro che ho intravisto in questa esperienza è fatto di collaborazione: persone e AI che lavorano insieme, ciascuno con i propri limiti e punti di forza. Forse può sembrare fantascienza, ma è già il nostro presente. E tutto continuerà ad evolversi.